最近读了一篇关于优化器的论文《DECOUPLED WEIGHT DECAY REGULARIZATION》,与大家分享。

在解读论文之前,有必要知道它的前因。L2正则化往损失函数加入权重惩罚项 。对于SGD,使用L2正则化后,参数更新公式变为公式(1):

因为 ,所以随着更新,

有趋向于零的倾向,从而选择特征向量的更少维度,提高泛化能力。但是,对于学习率自适应的Adam等优化器,使用L2正则化后,参数更新公式变为公式(2):

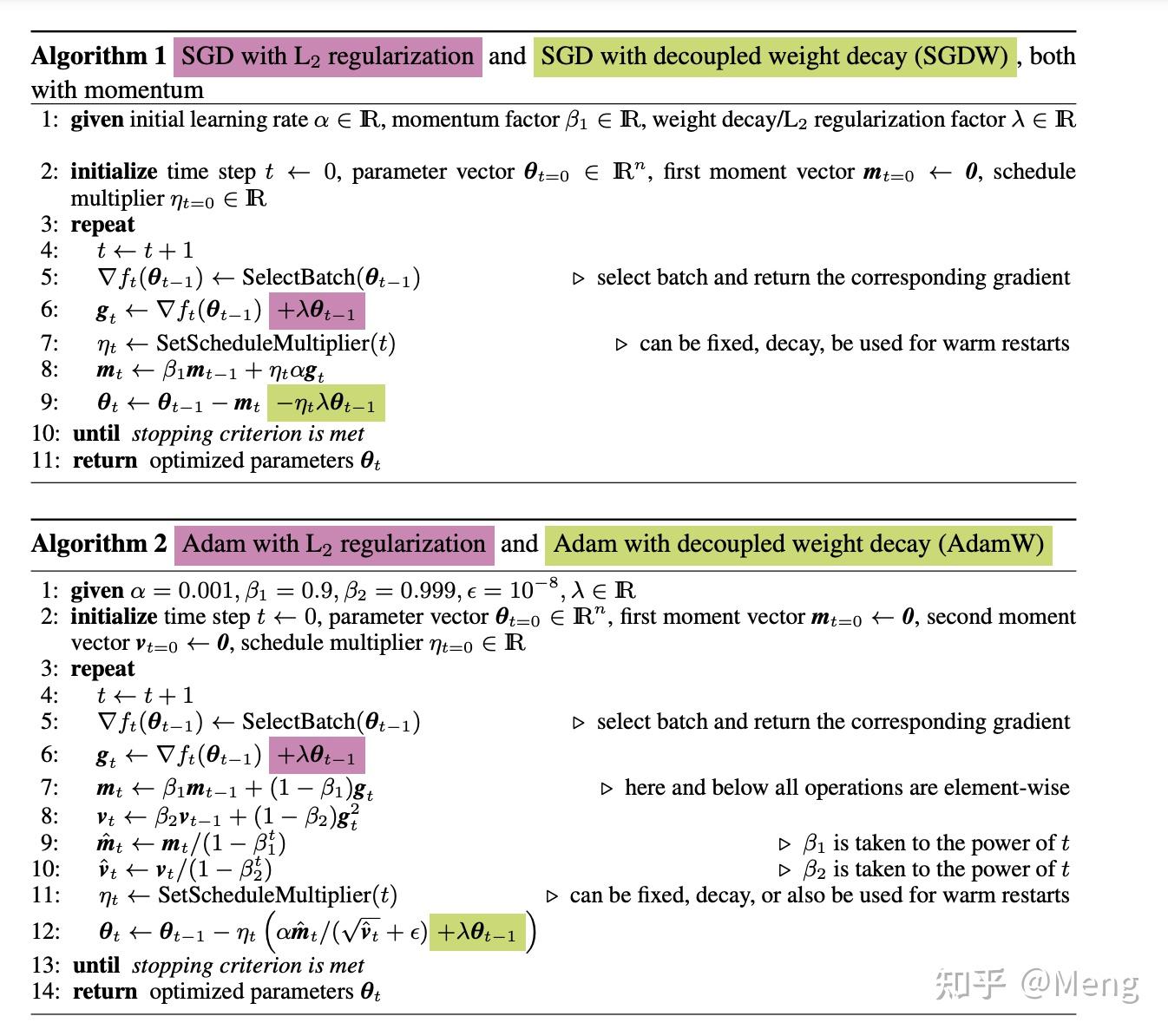

为了解决自适应学习率优化器,使用L2正则化后,效果不理想,AdamW提出了权重衰减,如下图1所示。

在一些测试实验中,SGDM + weight decay差于SGDM + L2 regularization,Adam + weight decay优于Adam + L2 regularization。

PyTorch中的SGDW本质上是SGD + l2 regularization。千万别被名字误导。

Copyright © 2012-2018 星云-星云娱乐新能源材料回收公司 版权所有 非商用版本 琼ICP备45612387号